Límite de 2 MB de Googlebot: qué ocurre cuando tus páginas son demasiado pesadas

Por CaptainDNS

Publicado el 10 de febrero de 2026

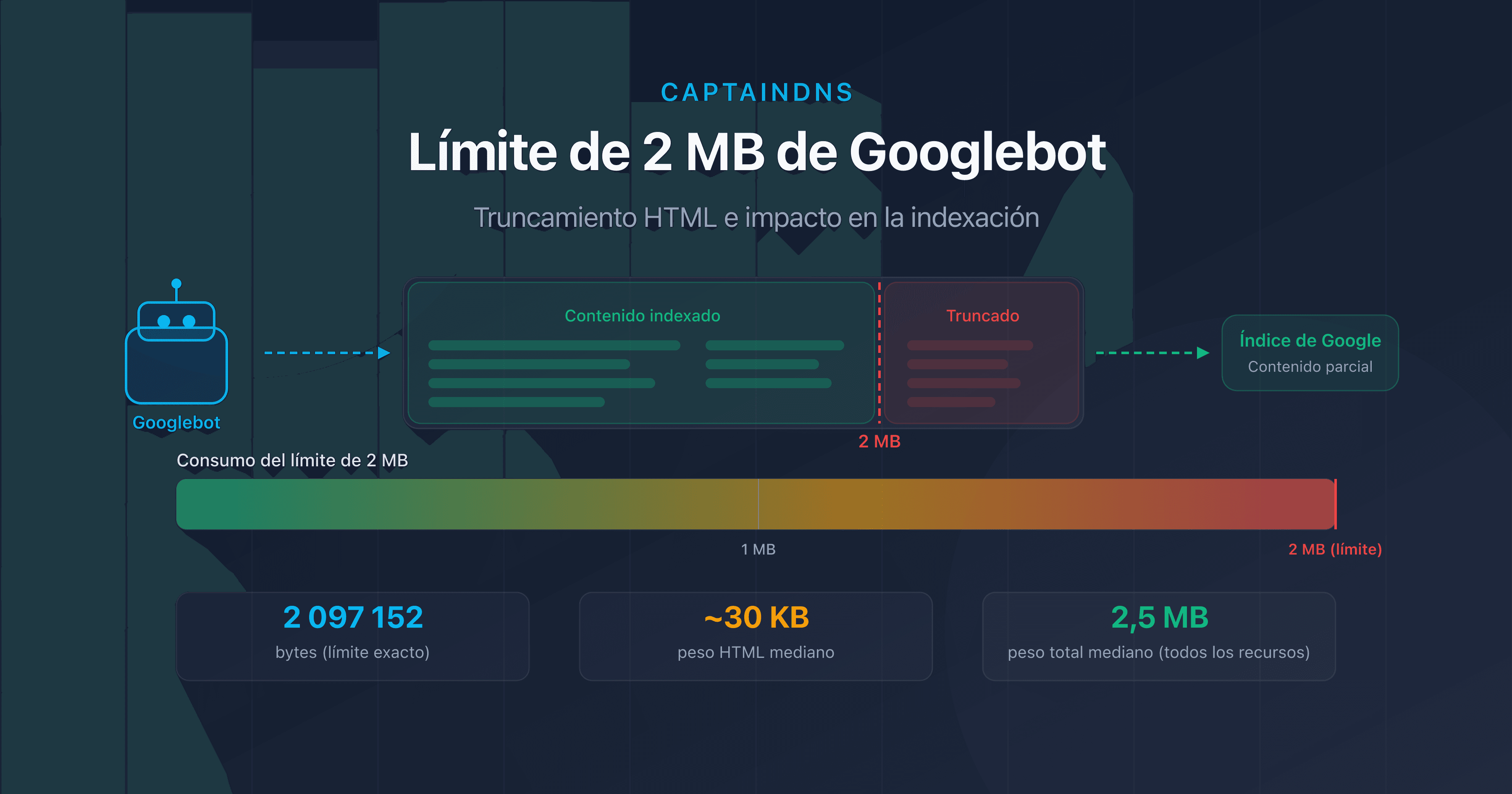

- Googlebot solo rastrea los primeros 2 MB (2 097 152 bytes) del código HTML de una página.

- Más allá de este límite, el contenido se trunca: los enlaces internos, los datos estructurados y el texto al final de la página desaparecen del índice.

- El peso medio de una página web supera los 2,5 MB de recursos totales en 2026, pero solo el HTML fuente cuenta para este límite.

- Comprueba tus páginas con nuestro Page Crawl Checker para verificar si están en riesgo.

¿Tu página tiene 2,1 MB de HTML? Google solo indexó el 95 %. El resto simplemente no existe para el motor de búsqueda.

A principios de febrero de 2026, Google actualizó su documentación técnica para recordar un punto que a menudo pasa desapercibido: Googlebot solo rastrea los primeros 2 megabytes del código fuente HTML de una página. Todo lo que supera este límite se ignora por completo durante la indexación.

Esta restricción existe desde hace varios años, pero cobra cada vez más importancia a medida que las páginas web se vuelven más pesadas. Frameworks JavaScript, imágenes inline en base64, Single Page Applications renderizadas en servidor: cada vez más páginas se acercan a esta frontera invisible.

En este artículo, detallamos el funcionamiento exacto de este límite, las situaciones de riesgo y las acciones concretas para protegerse. Tanto si eres especialista SEO, desarrollador front-end o responsable técnico, aquí encontrarás lo necesario para auditar y optimizar tus páginas.

¿Qué es el límite de 2 MB de Googlebot?

La documentación oficial de Google es explícita: "Googlebot crawls the first 2 MB of a supported file type" (Googlebot rastrea los primeros 2 MB de un tipo de archivo compatible). Esto equivale exactamente a 2 097 152 bytes de datos sin comprimir.

Algunas precisiones importantes:

- Lo que cuenta es el HTML fuente, no los recursos totales de la página (imágenes, CSS, JavaScript externos). Un archivo CSS de 500 KB cargado mediante

<link>no entra en el cálculo. - El límite se aplica al contenido sin comprimir. Aunque tu servidor utilice gzip o Brotli, es el tamaño descomprimido lo que Google mide.

- Cada recurso se evalúa individualmente. Un archivo JavaScript externo de 3 MB también se truncará a 2 MB, independientemente de la página HTML que lo cargue.

- El límite es idéntico para Googlebot Desktop y Googlebot Mobile. El cambio al mobile-first indexing no ha modificado este umbral.

Truncamiento HTML: ¿qué impacto tiene en el SEO?

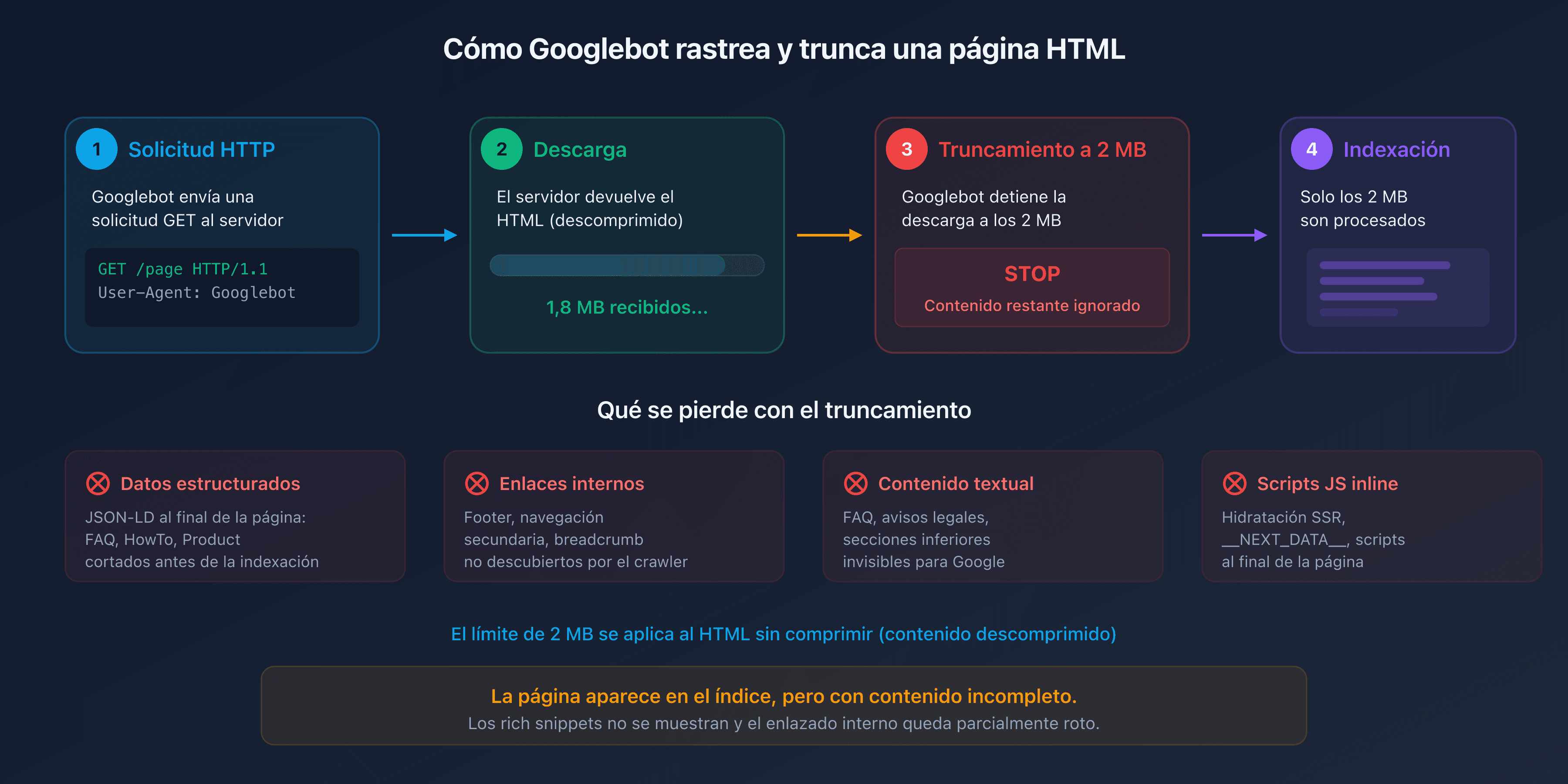

Cuando Googlebot alcanza el límite de 2 MB, deja de descargar el archivo HTML. La parte ya obtenida se envía al motor de indexación, pero todo lo que se encuentra después del corte es invisible para Google.

En la práctica, los elementos situados al final del documento HTML son los más expuestos:

- Los datos estructurados (JSON-LD al final de la página): los esquemas FAQPage, HowTo o Product colocados antes de la etiqueta

</body>pueden quedar truncados. - Los enlaces internos en el footer o la navegación secundaria: no serán descubiertos por el crawler.

- El contenido textual de las secciones inferiores: FAQ, avisos legales, condiciones generales.

- Los scripts JavaScript inline al final de la página: si tu framework inyecta contenido dinámico mediante un script al final de la página, nunca será ejecutado por el motor de renderizado de Google.

El resultado es insidioso. La página aparece en el índice, pero con contenido incompleto. Los rich snippets no se muestran, el enlazado interno queda parcialmente roto y el contenido editorial queda recortado.

¿A quién afecta?

¿Están tus páginas en riesgo? La mayoría de las páginas web no alcanzan los 2 MB de HTML fuente. Según HTTP Archive, el peso medio del HTML solo se sitúa alrededor de 30 KB en 2025. Pero ciertos casos hacen que este tamaño se dispare.

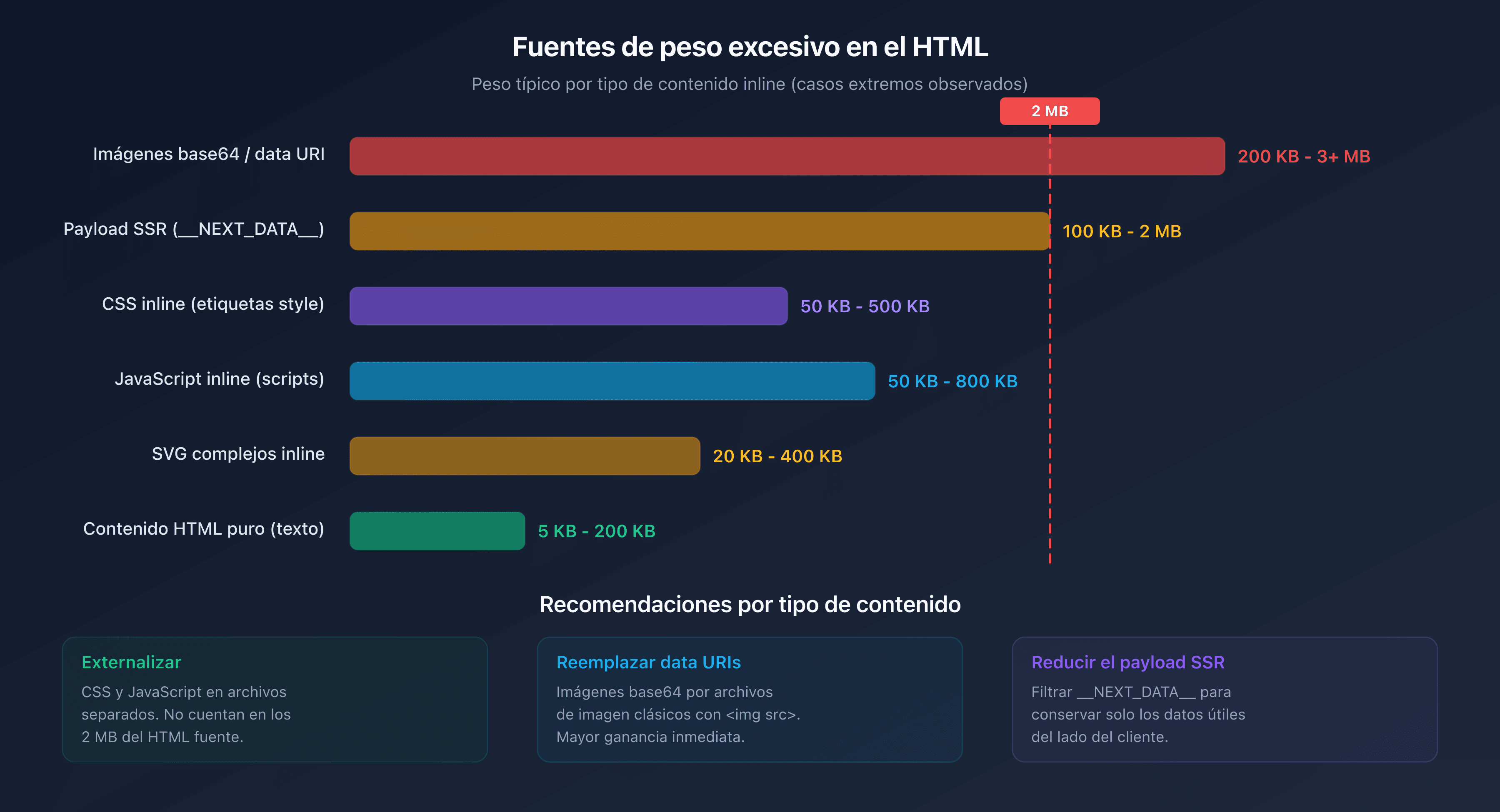

Páginas e-commerce con mega-catálogos

Las páginas de categoría que muestran cientos de productos con descripciones inline, atributos técnicos y reseñas de clientes pueden superar fácilmente 1 MB de HTML puro. Si se añaden datos estructurados Product para cada artículo, la barrera de los 2 MB se alcanza rápidamente.

Single Page Applications (SPA) con renderizado en servidor

Los frameworks como Next.js, Nuxt o SvelteKit inyectan un payload JSON voluminoso en una etiqueta <script> para la hidratación del lado del cliente. Este __NEXT_DATA__ o equivalente puede representar varios cientos de KB. En páginas con muchos datos, a menudo supera 1 MB por sí solo.

Imágenes y SVG inline

Las imágenes codificadas en base64 o los SVG complejos insertados directamente en el HTML aumentan considerablemente el peso del documento. Un solo SVG detallado puede pesar 200 KB. Tres o cuatro bastan para consumir una parte significativa del presupuesto de 2 MB.

JavaScript y CSS inline

Las páginas que incluyen CSS crítico o JavaScript directamente en etiquetas <style> y <script> en lugar de externalizarlos añaden peso innecesario al documento HTML.

Presupuesto de rastreo y peso de página

El presupuesto de rastreo (crawl budget) es el número de páginas que Googlebot puede rastrear en tu sitio en un intervalo de tiempo determinado. Depende de dos factores: la tasa de rastreo (crawl rate limit) y la demanda de rastreo (crawl demand).

El peso de las páginas afecta directamente a la tasa de rastreo. Cuanto más pesada es una página, más ancho de banda y tiempo de descarga consume. Pongamos un sitio de 100 000 páginas. La diferencia entre páginas de 50 KB y páginas de 500 KB de HTML se traduce en un factor de 10 en consumo de recursos.

En concreto:

- Páginas ligeras (<100 KB HTML): Googlebot puede rastrear miles de páginas por sesión.

- Páginas medianas (100 KB-500 KB): el rastreo se ralentiza notablemente.

- Páginas pesadas (500 KB-2 MB): el presupuesto de rastreo se consume rápidamente, las páginas profundas se rastrean con menor frecuencia.

- Páginas truncadas (>2 MB): además de desperdiciar el presupuesto, el contenido en el índice queda incompleto.

Para los sitios grandes, la optimización del peso HTML no es un lujo. Es una necesidad para garantizar que todas las páginas importantes se rastreen e indexen correctamente.

¿Cómo comprobar el peso de tus páginas?

Con las DevTools de Chrome

Abre las DevTools (F12), ve a la pestaña Network, recarga la página y filtra por Doc. La columna Size indica el peso transferido (comprimido) y la columna Content el peso descomprimido. Es este último valor el que cuenta para el límite de Googlebot.

Con el Page Crawl Checker de CaptainDNS

Nuestro Page Crawl Checker simula el comportamiento de Googlebot y muestra de inmediato:

- El peso del HTML fuente (comprimido y descomprimido)

- El porcentaje del límite de 2 MB consumido

- Los encabezados HTTP (Content-Type, Content-Encoding, Cache-Control)

- Un diagnóstico completo con recomendaciones de optimización

HTML fuente vs recursos totales

Un error frecuente consiste en mirar el peso total de la página (HTML + CSS + JS + imágenes) en lugar del HTML fuente solo. La cifra de 2,5 MB que se cita a menudo como peso medio de una página web incluye todos los recursos. El HTML solo representa generalmente entre el 1 % y el 5 % de ese total.

¿Cómo reducir el peso de tus páginas HTML?

¿Por dónde empezar? Si tus páginas se acercan al límite o si deseas optimizar tu presupuesto de rastreo, estas son las acciones más eficaces.

Externalizar CSS y JavaScript

Mueve todo el CSS y el JavaScript inline a archivos externos. Estos archivos se cargarán por separado y no cuentan en los 2 MB del documento HTML.

<!-- Antes: CSS inline (pesa en el HTML) -->

<style>

.product-card \{ ... 500 líneas de CSS ... \}

</style>

<!-- Después: CSS externalizado (no pesa en el HTML) -->

<link rel="stylesheet" href="/css/products.css">

Eliminar las imágenes inline

Reemplaza las imágenes en base64 y las data URI por archivos de imagen clásicos referenciados mediante <img src="...">.

Minificar el HTML

Elimina los espacios innecesarios, los comentarios HTML y los atributos redundantes. Herramientas como html-minifier o los plugins de build (Webpack, Vite) automatizan esta tarea.

Activar la compresión del servidor

Configura gzip o Brotli en tu servidor web. Esto reduce el volumen transferido (y por tanto el tiempo de rastreo), aunque el límite de 2 MB se aplica al contenido descomprimido.

Paginar las listas largas

Para las páginas de categoría e-commerce, implementa una paginación adecuada con etiquetas <link rel="next"> y <link rel="prev"> en lugar de mostrar todos los productos en una sola página.

Reducir el payload de hidratación

Si utilizas un framework SSR (Next.js, Nuxt), examina el contenido de __NEXT_DATA__ o equivalente. A menudo, datos innecesarios del lado del cliente se serializan allí. Filtra las props transmitidas para conservar solo lo estrictamente necesario.

Plan de acción recomendado

- Comprueba tus páginas críticas: utiliza el Page Crawl Checker en tus 10-20 páginas más importantes (inicio, categorías, productos destacados, landing pages).

- Identifica las páginas en riesgo: toda página cuyo HTML fuente supere los 500 KB merece un examen. Por encima de 1 MB, la optimización es urgente.

- Optimiza: externaliza el CSS/JS inline, elimina las imágenes base64, minifica el HTML y activa la compresión del servidor.

FAQ

¿Cuál es el peso medio de una página web en 2026?

Según HTTP Archive, el peso medio total de una página web (HTML + CSS + JS + imágenes) alcanza aproximadamente 2,5 MB en escritorio y 2,2 MB en móvil en 2026. El HTML fuente solo pesa en promedio alrededor de 30 KB. El límite de 2 MB de Googlebot se aplica únicamente al HTML fuente, no a los recursos totales.

¿Qué ocurre si una página supera los 2 MB de HTML?

Googlebot detiene la descarga después de 2 MB (2 097 152 bytes) de HTML sin comprimir. Solo el contenido ya descargado se envía a indexación. El resto (enlaces internos, datos estructurados, texto al final de la página) se ignora. La página aparece en el índice, pero con contenido incompleto.

¿Cómo conocer el peso HTML de una página web?

Abre las DevTools de Chrome (F12), pestaña Network, filtra por "Doc" y mira la columna "Content" (tamaño descomprimido). También puedes utilizar nuestro Page Crawl Checker, que muestra directamente el peso del HTML fuente y el porcentaje del límite de 2 MB consumido.

¿El límite de 2 MB se aplica a los datos comprimidos?

No. El límite de 2 MB se aplica al contenido descomprimido. Aunque tu servidor utilice gzip o Brotli para la transmisión, es el tamaño del HTML una vez descomprimido lo que tiene en cuenta Googlebot. La compresión sigue siendo útil para acelerar la transferencia, pero no permite eludir el límite.

¿Cómo reducir el peso de una página HTML?

Las acciones más eficaces: externalizar el CSS y el JavaScript (archivos separados en lugar de etiquetas inline), eliminar las imágenes en base64, minificar el HTML, paginar las listas largas y reducir el payload de hidratación de los frameworks SSR (Next.js, Nuxt). Activa también la compresión del servidor (gzip o Brotli).

¿Qué es el presupuesto de rastreo?

El presupuesto de rastreo (crawl budget) es el número de páginas que Googlebot puede rastrear en tu sitio en un intervalo de tiempo determinado. Depende de la tasa de rastreo (ancho de banda que Google asigna a tu sitio) y de la demanda de rastreo (páginas que Google desea actualizar). Las páginas pesadas consumen más presupuesto, lo que reduce la frecuencia de rastreo de las demás páginas.

¿Googlebot Mobile y Desktop tienen el mismo límite de 2 MB?

Sí. El límite de 2 MB es idéntico para Googlebot Desktop y Googlebot Mobile (Googlebot Smartphone). El cambio al mobile-first indexing no ha modificado este umbral. Las dos variantes del crawler aplican la misma regla de truncamiento.

Comprueba tus páginas ahora: utiliza nuestro Page Crawl Checker para verificar de inmediato si tus páginas respetan el límite de 2 MB de Googlebot.

Guías de rastreo e indexación relacionadas

- Crawl budget y optimización (próximamente)

- Peso medio de las páginas web 2025 (próximamente)

Fuentes

- Google Developers. Googlebot overview: documentación oficial que menciona el límite de 2 MB.

- HTTP Archive. Web Almanac: estadísticas sobre el peso de las páginas web.

- web.dev. Reduce the scope and complexity of style calculations: buenas prácticas de optimización.

- Google Search Central. Crawl budget management: gestión del presupuesto de rastreo para sitios grandes.