Limite de 2 MB do Googlebot: o que acontece quando suas páginas são pesadas demais

Por CaptainDNS

Publicado em 10 de fevereiro de 2026

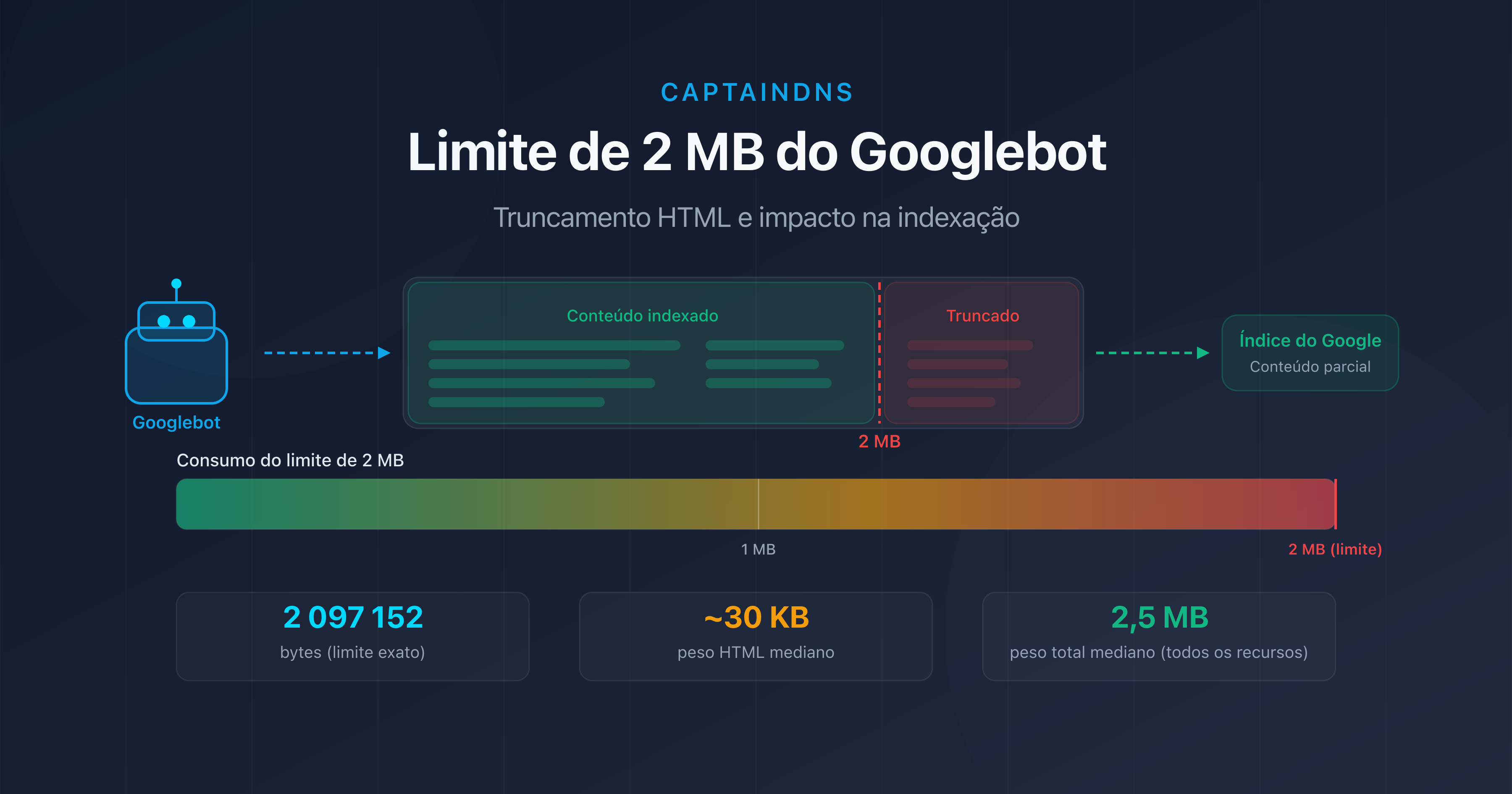

- O Googlebot rastreia apenas os 2 primeiros MB (2.097.152 bytes) do código HTML de uma página.

- Além desse limite, o conteúdo é truncado: links internos, dados estruturados e texto no final da página desaparecem do índice.

- O peso mediano de uma página web ultrapassa 2,5 MB de recursos totais em 2026, mas apenas o HTML fonte conta para esse limite.

- Teste suas páginas com nosso Page Crawl Checker para verificar se elas estão em risco.

Sua página tem 2,1 MB de HTML? O Google indexou apenas 95% dela. O restante simplesmente não existe para o mecanismo de busca.

No início de fevereiro de 2026, o Google atualizou sua documentação técnica para reforçar um ponto frequentemente desconhecido: o Googlebot rastreia apenas os 2 primeiros megabytes do código-fonte HTML de uma página. Tudo o que ultrapassar esse limite é ignorado durante a indexação.

Essa restrição existe há vários anos, mas sua importância cresce à medida que as páginas web ficam mais pesadas. Frameworks JavaScript, imagens inline em base64, Single Page Applications renderizadas no servidor: cada vez mais páginas se aproximam dessa fronteira invisível.

Neste artigo, detalhamos o funcionamento exato desse limite, as situações de risco e as ações concretas para se proteger. Seja você profissional de SEO, desenvolvedor front-end ou responsável técnico, encontrará aqui o necessário para auditar e otimizar suas páginas.

O que é o limite de 2 MB do Googlebot?

A documentação oficial do Google é explícita: "Googlebot crawls the first 2 MB of a supported file type" (o Googlebot rastreia os 2 primeiros MB de um tipo de arquivo suportado). Isso representa exatamente 2.097.152 bytes de dados não comprimidos.

Algumas precisões importantes:

- É o HTML fonte que conta, não os recursos totais da página (imagens, CSS, JavaScript externos). Um arquivo CSS de 500 KB carregado via

<link>não entra no cálculo. - O limite se aplica ao conteúdo não comprimido. Mesmo que o seu servidor use gzip ou Brotli, é o tamanho descomprimido que o Google mede.

- Cada recurso é avaliado individualmente. Um arquivo JavaScript externo de 3 MB também será truncado em 2 MB, independentemente da página HTML que o carrega.

- O limite é idêntico para o Googlebot Desktop e o Googlebot Mobile. A mudança para o mobile-first indexing não alterou esse limite.

Truncagem HTML: qual o impacto no SEO?

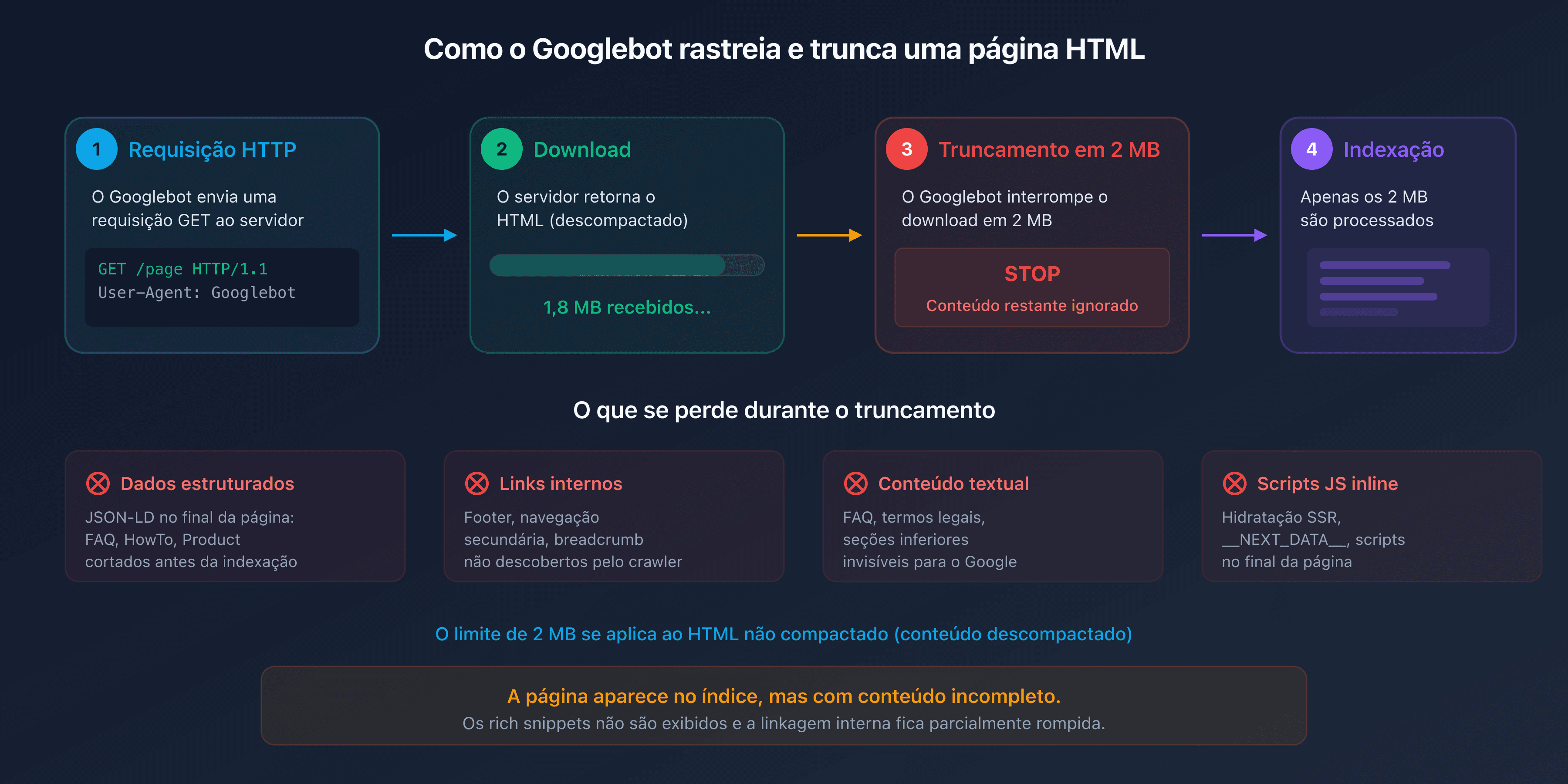

Quando o Googlebot atinge o limite de 2 MB, ele para de baixar o arquivo HTML. A parte já recuperada é enviada ao mecanismo de indexação, mas tudo o que estiver após o corte fica invisível para o Google.

Na prática, os elementos situados no final do documento HTML são os mais expostos:

- Os dados estruturados (JSON-LD no final da página): os schemas FAQPage, HowTo ou Product posicionados antes da tag

</body>correm risco de serem cortados. - Os links internos no footer ou na navegação secundária: eles não serão descobertos pelo crawler.

- O conteúdo textual das seções inferiores: FAQ, avisos legais, termos e condições.

- Os scripts JavaScript inline posicionados no final da página: se o seu framework injeta conteúdo dinâmico por meio de um script no final da página, ele nunca será executado pelo mecanismo de renderização do Google.

O resultado é traiçoeiro. A página aparece no índice, mas com conteúdo incompleto. Os rich snippets não são exibidos, a linkagem interna é parcialmente rompida e o conteúdo editorial é amputado.

Quem é afetado?

Suas páginas estão em risco? A maioria das páginas web não atinge 2 MB de HTML fonte. Segundo o HTTP Archive, o peso mediano do HTML puro fica em torno de 30 KB em 2025. Porém, certas situações fazem esse tamanho disparar.

Páginas de e-commerce com mega catálogos

As páginas de categoria que exibem centenas de produtos com descrições inline, atributos técnicos e avaliações de clientes podem facilmente ultrapassar 1 MB de HTML puro. Adicione dados estruturados Product para cada item e o limite de 2 MB é rapidamente atingido.

Single Page Applications (SPA) com renderização no servidor

Frameworks como Next.js, Nuxt ou SvelteKit injetam um payload JSON volumoso em uma tag <script> para a hidratação no lado do cliente. Esse __NEXT_DATA__ ou equivalente pode representar várias centenas de KB. Em páginas ricas em dados, frequentemente ultrapassa 1 MB sozinho.

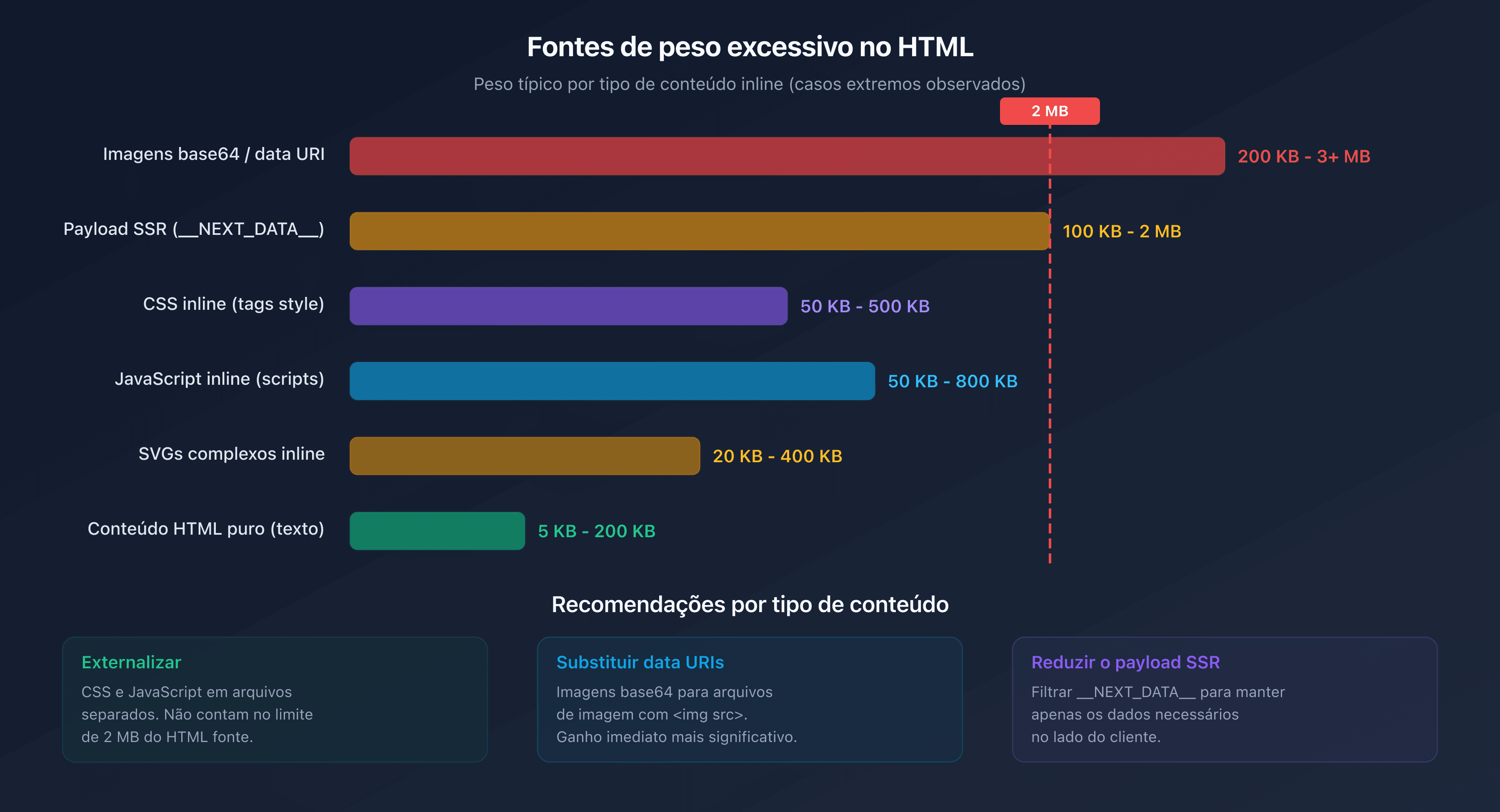

Imagens e SVG inline

As imagens codificadas em base64 ou os SVGs complexos inseridos diretamente no HTML inflam consideravelmente o peso do documento. Um único SVG detalhado pode pesar 200 KB. Três ou quatro são suficientes para consumir uma parte significativa do orçamento de 2 MB.

JavaScript e CSS inline

As páginas que incorporam CSS crítico ou JavaScript diretamente em tags <style> e <script> em vez de externalizá-los adicionam peso desnecessário ao documento HTML.

Orçamento de rastreamento e peso de página

O orçamento de rastreamento (crawl budget) é o número de páginas que o Googlebot consegue rastrear no seu site em um determinado intervalo de tempo. Ele depende de dois fatores: a taxa de rastreamento (crawl rate limit) e a demanda de rastreamento (crawl demand).

O peso das páginas afeta diretamente a taxa de rastreamento. Quanto mais pesada uma página, mais largura de banda e tempo de download ela consome. Considere um site com 100.000 páginas. A diferença entre páginas de 50 KB e páginas de 500 KB de HTML se traduz em um fator de 10 no consumo de recursos.

Na prática:

- Páginas leves (<100 KB HTML): o Googlebot consegue rastrear milhares de páginas por sessão.

- Páginas médias (100 KB-500 KB): o rastreamento desacelera sensivelmente.

- Páginas pesadas (500 KB-2 MB): o orçamento de rastreamento é consumido rapidamente, as páginas profundas são rastreadas com menos frequência.

- Páginas truncadas (>2 MB): além de desperdiçar o orçamento, o conteúdo fica incompleto no índice.

Para sites grandes, a otimização do peso HTML não é um luxo. É uma necessidade para garantir que todas as páginas importantes sejam rastreadas e indexadas corretamente.

Como testar o peso das suas páginas?

Com o DevTools do Chrome

Abra o DevTools (F12), vá até a aba Network, recarregue a página e filtre por Doc. A coluna Size indica o peso transferido (comprimido) e a coluna Content o peso descomprimido. É esse último valor que conta para o limite do Googlebot.

Com o Page Crawl Checker do CaptainDNS

Nosso Page Crawl Checker simula o comportamento do Googlebot e exibe imediatamente:

- O peso do HTML fonte (comprimido e descomprimido)

- A porcentagem do limite de 2 MB consumida

- Os cabeçalhos HTTP (Content-Type, Content-Encoding, Cache-Control)

- Um diagnóstico completo com recomendações de otimização

HTML fonte vs recursos totais

Uma confusão frequente é olhar o peso total da página (HTML + CSS + JS + imagens) em vez do HTML fonte sozinho. O valor de 2,5 MB frequentemente citado como peso mediano de uma página web inclui todos os recursos. O HTML puro geralmente representa entre 1% e 5% desse total.

Como reduzir o peso das suas páginas HTML?

Por onde começar? Se suas páginas se aproximam do limite ou se você deseja otimizar seu orçamento de rastreamento, estas são as ações mais eficazes.

Externalizar CSS e JavaScript

Mova todo o CSS e o JavaScript inline para arquivos externos. Esses arquivos serão carregados separadamente e não contam nos 2 MB do documento HTML.

<!-- Antes: CSS inline (pesa no HTML) -->

<style>

.product-card \{ ... 500 linhas de CSS ... \}

</style>

<!-- Depois: CSS externalizado (não pesa no HTML) -->

<link rel="stylesheet" href="/css/products.css">

Remover imagens inline

Substitua as imagens em base64 e os data URIs por arquivos de imagem convencionais referenciados via <img src="...">.

Minificar o HTML

Remova os espaços desnecessários, os comentários HTML e os atributos redundantes. Ferramentas como html-minifier ou os plugins de build (Webpack, Vite) automatizam essa tarefa.

Ativar a compressão no servidor

Configure gzip ou Brotli no seu servidor web. Isso reduz o volume transferido (e portanto o tempo de rastreamento), mesmo que o limite de 2 MB se aplique ao conteúdo descomprimido.

Paginar listas longas

Para páginas de categoria de e-commerce, implemente uma paginação adequada com tags <link rel="next"> e <link rel="prev"> em vez de exibir todos os produtos em uma única página.

Reduzir o payload de hidratação

Se você usa um framework SSR (Next.js, Nuxt), examine o conteúdo de __NEXT_DATA__ ou equivalente. Muitas vezes, dados desnecessários no lado do cliente são serializados ali. Filtre as props transmitidas para manter apenas o estritamente necessário.

Plano de ação recomendado

- Testar suas páginas críticas: use o Page Crawl Checker nas suas 10 a 20 páginas mais importantes (home, categorias, produtos principais, landing pages).

- Identificar as páginas em risco: qualquer página cujo HTML fonte ultrapasse 500 KB merece análise. Acima de 1 MB, a otimização é urgente.

- Otimizar: externalize o CSS/JS inline, remova as imagens base64, minifique o HTML e ative a compressão no servidor.

FAQ

Qual é o peso médio de uma página web em 2026?

Segundo o HTTP Archive, o peso mediano total de uma página web (HTML + CSS + JS + imagens) atinge cerca de 2,5 MB no desktop e 2,2 MB no mobile em 2026. O HTML fonte puro pesa em mediana cerca de 30 KB. O limite de 2 MB do Googlebot se aplica apenas ao HTML fonte, não aos recursos totais.

O que acontece se uma página ultrapassar 2 MB de HTML?

O Googlebot interrompe o download após 2 MB (2.097.152 bytes) de HTML não comprimido. Apenas o conteúdo já baixado é enviado para indexação. O restante (links internos, dados estruturados, texto no final da página) é ignorado. A página aparece no índice, mas com conteúdo incompleto.

Como saber o peso HTML de uma página web?

Abra o DevTools do Chrome (F12), aba Network, filtre por "Doc" e observe a coluna "Content" (tamanho descomprimido). Você também pode usar nosso Page Crawl Checker, que exibe diretamente o peso do HTML fonte e a porcentagem do limite de 2 MB consumida.

O limite de 2 MB se aplica aos dados comprimidos?

Não. O limite de 2 MB se aplica ao conteúdo descomprimido. Mesmo que seu servidor use gzip ou Brotli para a transmissão, é o tamanho do HTML após descompressão que é considerado pelo Googlebot. A compressão continua útil para acelerar a transferência, mas não permite contornar o limite.

Como reduzir o peso de uma página HTML?

As ações mais eficazes: externalizar o CSS e o JavaScript (arquivos separados em vez de tags inline), remover as imagens em base64, minificar o HTML, paginar listas longas e reduzir o payload de hidratação dos frameworks SSR (Next.js, Nuxt). Ative também a compressão no servidor (gzip ou Brotli).

O que é o orçamento de rastreamento?

O orçamento de rastreamento (crawl budget) é o número de páginas que o Googlebot consegue rastrear no seu site em um determinado intervalo de tempo. Ele depende da taxa de rastreamento (largura de banda que o Google concede ao seu site) e da demanda de rastreamento (páginas que o Google deseja atualizar). Páginas pesadas consomem mais orçamento, o que reduz a frequência de rastreamento das demais páginas.

O Googlebot Mobile e Desktop têm o mesmo limite de 2 MB?

Sim. O limite de 2 MB é idêntico para o Googlebot Desktop e o Googlebot Mobile (Googlebot Smartphone). A mudança para o mobile-first indexing não alterou esse limite. As duas variantes do crawler aplicam a mesma regra de truncagem.

Teste suas páginas agora: use nosso Page Crawl Checker para verificar instantaneamente se suas páginas respeitam o limite de 2 MB do Googlebot.

Guias de rastreio e indexação relacionados

- Orçamento de rastreamento e otimização (em breve)

- Peso mediano das páginas web 2025 (em breve)

Fontes

- Google Developers. Googlebot overview: documentação oficial mencionando o limite de 2 MB.

- HTTP Archive. Web Almanac: estatísticas sobre o peso das páginas web.

- web.dev. Reduce the scope and complexity of style calculations: boas práticas de otimização.

- Google Search Central. Crawl budget management: gerenciamento do orçamento de rastreamento para sites grandes.